Un mémo sur la mise en place d’un cluster en haute disponibilité d’hyperviseurs Proxmox avec un stockage distribuée et redondant Ceph. Cet article traite uniquement de la mise en cluster des noeuds Proxmox ainsi que l’installation et de la configuration de Ceph.

Image may be NSFW.

Clik here to view.

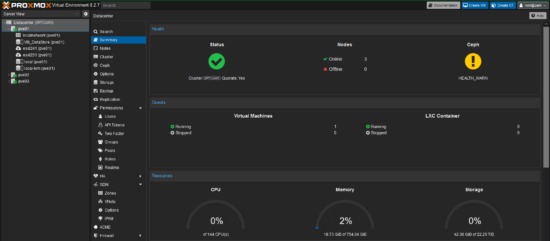

Configuration Réseau des noeuds Proxmox

Chaque réseau sera cablé en topologie MESH et les interfaces réseaux créés dans Proxmox seront des aggrégations en mode Broadcast.

Pour plus d’infos voir cet article : https://memo-linux.com/proxmox-creer-un-cluster-sur-un-reseau-prive-sans-switch/

- Adresse IP public des noeuds Proxmox :

- pve01 : 10.x.x.1

- pve01 : 10.x.x.2

- pve01 : 10.x.x.3

- Réseau Corosync (cluster Proxmox) : 192.168.254.0/24

- pve01 : 192.168.254.1

- pve02 : 192.168.254.2

- pve03 : 192.168.254.3

- Réseau Ceph :

- Ceph Public 192.168.252.0/24

- pve01 : 192.168.252.1

- pve02 : 192.168.252.2

- pve03 : 192.168.252.3

- Ceph Cluster 192.168.253.0/24

- pve01 : 192.168.253.1

- pve02 : 192.168.253.2

- pve03 : 192.168.253.3

- Ceph Public 192.168.252.0/24

Image may be NSFW.

Clik here to view.

Mise en cluster des noeuds Proxmox

Avant la mise en cluster, il faut s’assurer absolument que chaque noeud soit à l’heure et synchronisé sur un serveur NTP.

chronyc tracking

Image may be NSFW.

Clik here to view.![]()

- Initialisation du cluster sur un noeud aux choix :

pvecm create nom_cluster --link0 192.168.254.1

- Sur pve02 :

pvecm add 10.x.x.1 --link0 192.168.254.2

pvecm add 10.x.x.1 --link0 192.168.254.3

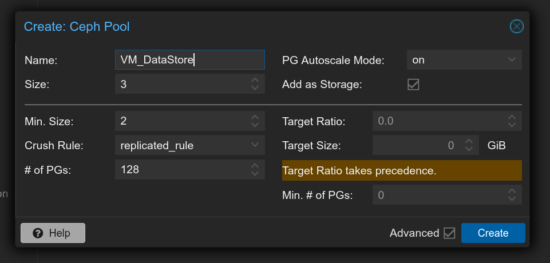

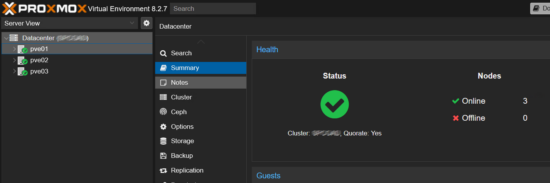

Image may be NSFW.

Clik here to view.

Installation de Ceph

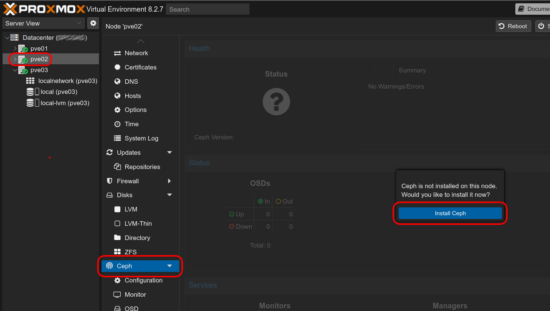

L’installation et la configuration du Ceph sera réalisée via l’interface web de Proxmox.

- Sélectionner un noeud, dans le menu cliquer sur Ceph puis cliquer sur « Install Ceph » :

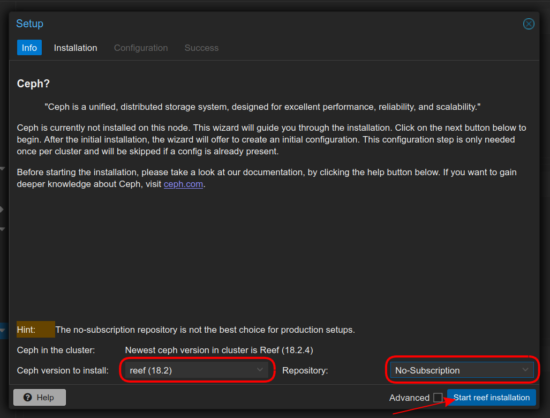

- Une nouvelle fenêtre s’ouvre, sélectionner la dernière version de Ceph (Reef) et le dépôt No-Subscription puis cliquer sur « Start reef installation » :

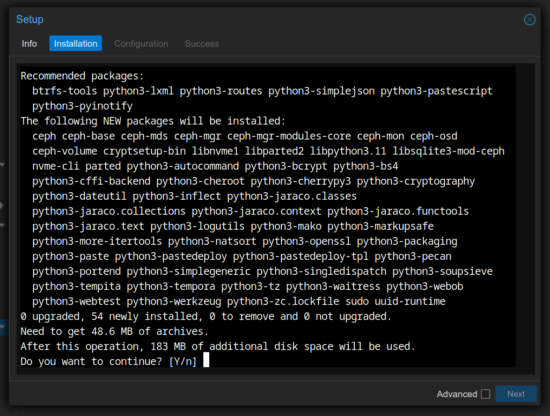

- Répondre « Y » puis la touche « Enter » du clavier :

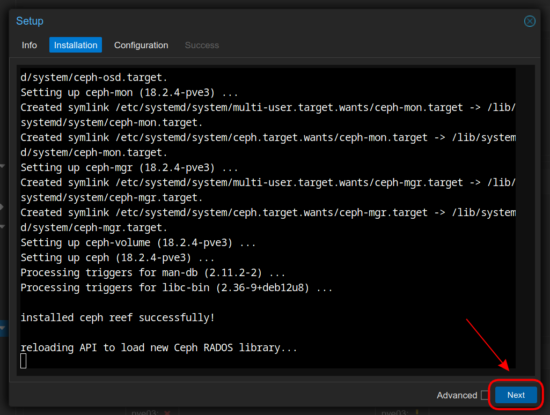

- Une fois l’installation terminée, cliquer sur « Next » :

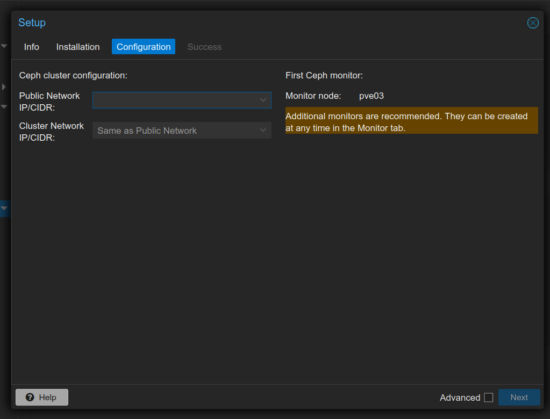

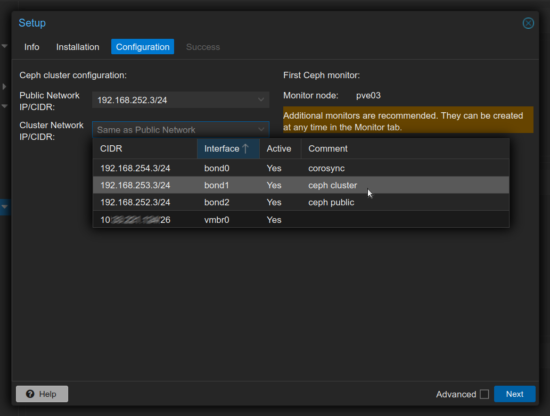

- Configuration réseau du cluster de Ceph :

- Sélectionner les adresses IP configurées pour chaque réseau Public et Cluster du Ceph :

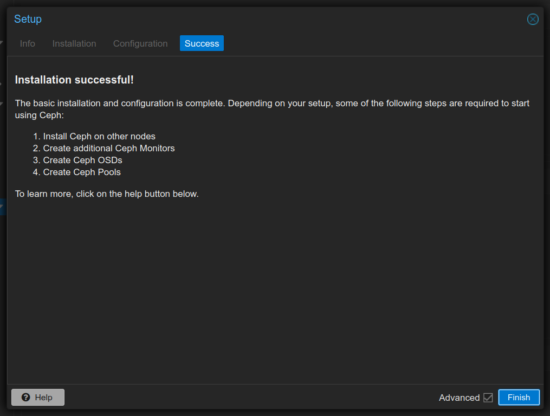

- Installation et configuration du Ceph terminée :

Image may be NSFW.

Clik here to view.

Image may be NSFW.

Clik here to view.

Image may be NSFW.

Clik here to view.

Image may be NSFW.

Clik here to view.

Image may be NSFW.

Clik here to view.

Image may be NSFW.

Clik here to view.

Cependant, il faut refaire l’étape d’installation du Ceph sur les autres noeuds (sans la partie réseau).

Mise en place du Ceph sur le cluster Proxmox

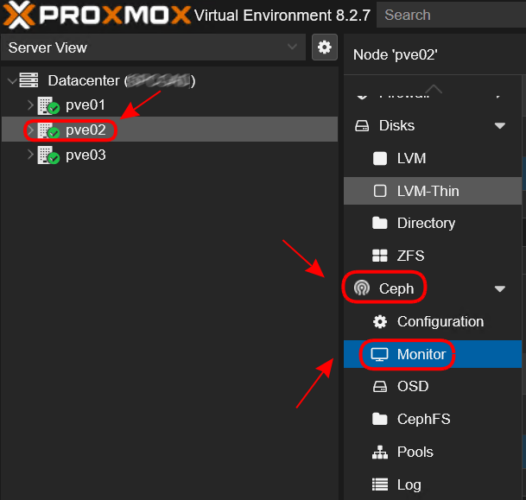

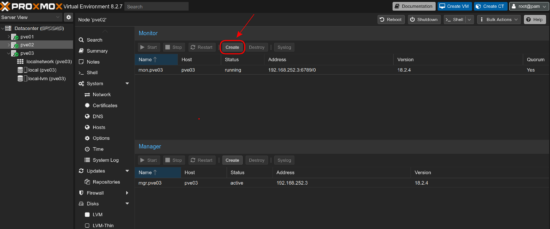

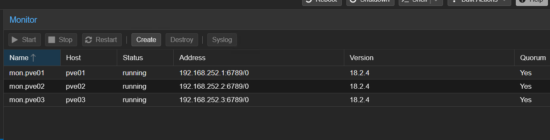

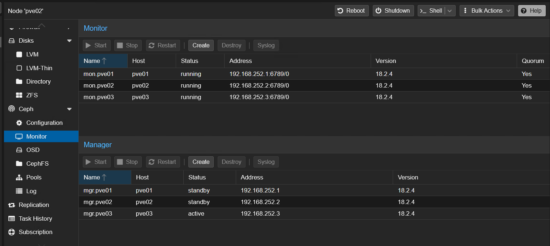

- Sur chaque noeud, créer le Ceph Monitors :

- Cliquer dans le menu Ceph, puis cliquer sur Monitor :

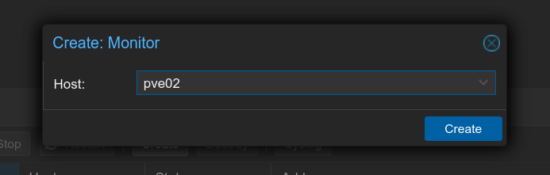

- Cliquer cur « Create » :

- Sélectionner le noeud :

- Répéter l’opération sur l’autre noeud afin d’avoir l’ensemble des monitors :

Image may be NSFW.

Clik here to view.![]()

Image may be NSFW.

Clik here to view.![]()

Image may be NSFW.

Clik here to view.![]()

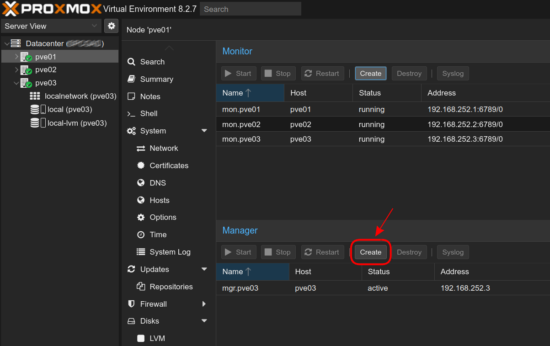

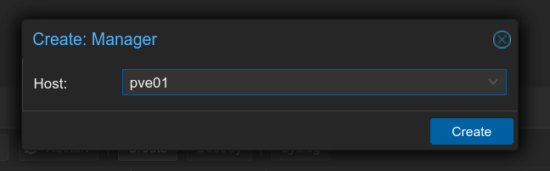

- Sur chaque noeud, créer le Ceph Manager :

- Toujours dans le menu Monitor, au niveau de Manager cliquer sur « Create » :

- Sélectioner le noeud :

- Répéter l’opération sur l’autre noeud afin d’avoir tous les Managers (à savoir, un seul est actif) :

Image may be NSFW.

Clik here to view.![]()

Image may be NSFW.

Clik here to view.![]()

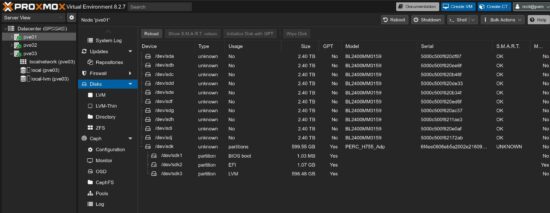

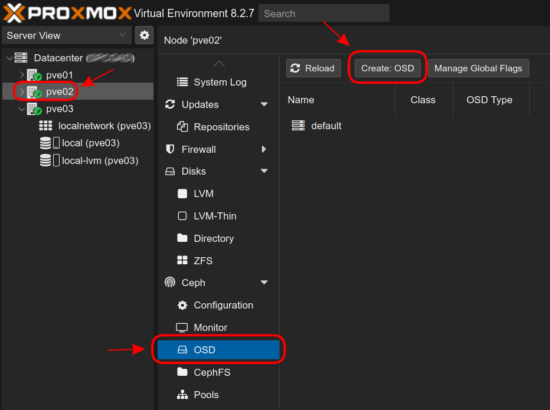

- Création des OSD :

- Pré-requis, il faut que les disques soient configurés en NON-RAID et visible dans le menu « Disks » :

- Opération à réaliser sur chaque noeud, dans le menu Ceph, cliquer sur OSD puis sur « Create: OSD » :

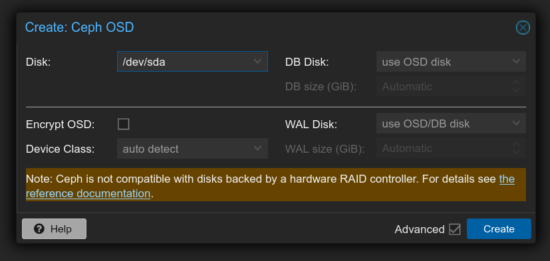

- Sélectionner le premier disque puis cliquer sur « Create » :

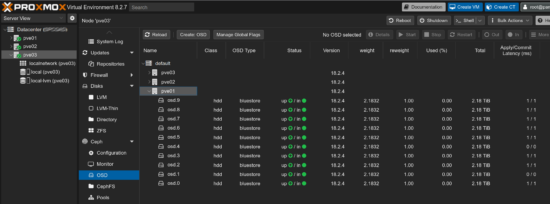

- Répéter l’opération pour l’ensemble des disques :

Image may be NSFW.

Clik here to view.![]()

Image may be NSFW.

Clik here to view.![]()

Image may be NSFW.

Clik here to view.![]()

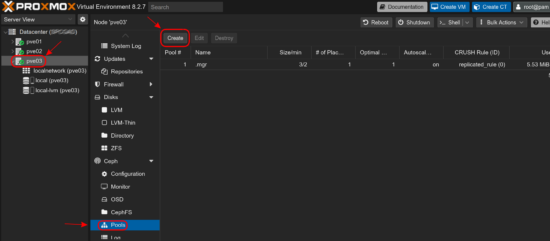

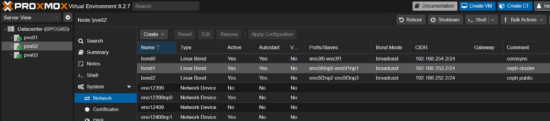

- Création du pool Ceph pour le stockage :

- Toujours dans le menu Ceph, cliquer sur « Pools » puis sur « Create » :

- Donner un nom au pool Ceph puis cliquer sur « Create » :

- Une fois le pool Ceph créé, le stockage est automatiquement créé et partagé aux membres du cluster Proxmox :

Image may be NSFW.

Clik here to view.![]()

Image may be NSFW.

Clik here to view.![]()

Mise en place de la HA pour les VMs

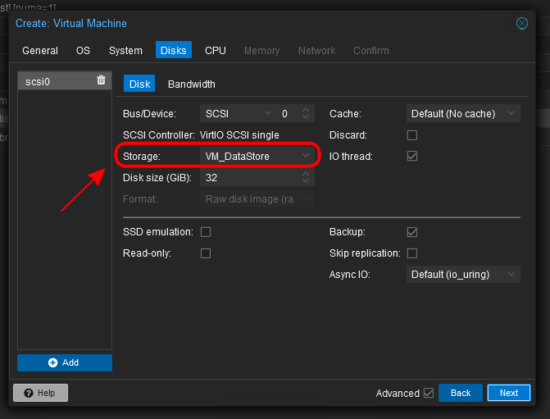

nb: Lors de la création d’une machine virtuelle, ne pas oublier de choisir le stockage correspondant au pool Ceph:

Image may be NSFW.

Clik here to view.

Encore à ce jour pour la gestion HA des machines virtuelles, j’utilise cette méthode -> https://memo-linux.com/proxmox-cluster-ha-repartition-de-charge-des-machines-virtuelles/